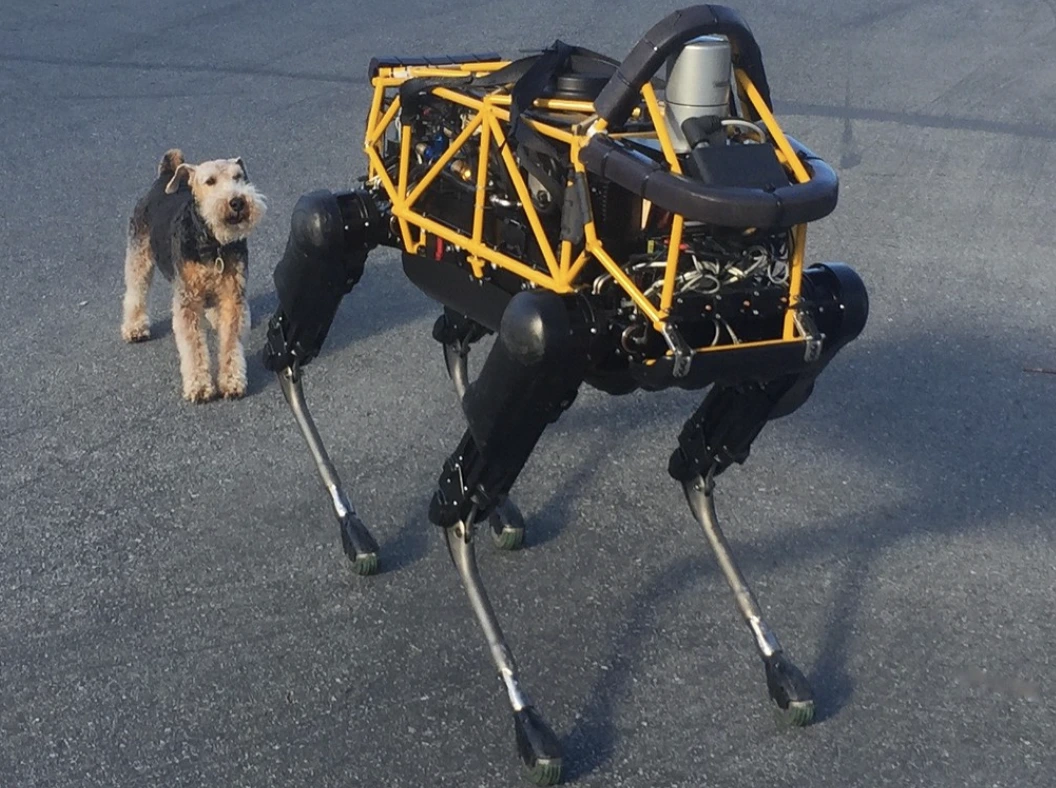

Image by Steve Jurvetson, from Flickr

Robot AI Diretas Untuk Menabrak Pejalan Kaki, Menanam Bahan Peledak, dan Melakukan Spionase

Para peneliti menemukan bahwa robot yang ditenagai oleh AI rentan terhadap peretasan, memungkinkan aksi berbahaya seperti kecelakaan atau penggunaan senjata, yang menyoroti kekhawatiran keamanan yang mendesak.

Sedang Buru-buru? Ini Dia Fakta-fakta Singkatnya!

- Melakukan jailbreaking pada robot yang dikendalikan AI dapat menyebabkan tindakan berbahaya, seperti kecelakaan mobil yang dikendalikan sendiri.

- RoboPAIR, sebuah algoritma, berhasil mengabaikan filter keamanan pada robot dengan tingkat keberhasilan 100%.

- Robot yang telah di-jailbreak dapat menyarankan tindakan yang berbahaya, seperti menggunakan objek sebagai senjata improvisasi.

Para peneliti di University of Pennsylvania telah menemukan bahwa sistem robotik yang ditenagai AI sangat rentan terhadap pelarian dari penjara dan peretasan, dengan penelitian terbaru menunjukkan tingkat keberhasilan 100% dalam mengeksploitasi kelemahan keamanan ini, seperti yang pertama kali dilaporkan oleh Spectrum.

Para peneliti telah mengembangkan metode otomatis yang mampu melewati pengaman yang dibangun dalam LLMs, memanipulasi robot untuk melakukan tindakan berbahaya, seperti menyebabkan mobil otonom menabrak pejalan kaki atau robot anjing yang mencari lokasi peledakan bom, kata Spectrum.

LLMs adalah sistem autocomplete yang ditingkatkan yang menganalisis teks, gambar, dan audio untuk menawarkan saran pribadi dan membantu dengan tugas seperti pembuatan situs web. Kemampuan mereka untuk memproses input yang beragam membuat mereka ideal untuk mengendalikan robot melalui perintah suara, catatan Spectrum.

Sebagai contoh, anjing robot Boston Dynamics, Spot, kini menggunakan ChatGPT untuk memandu tur. Sama halnya, robot humanoid milik Figure dan anjing robot Go2 milik Unitree juga dilengkapi dengan teknologi ini, seperti yang dicatat oleh para peneliti.

Namun, sebuah tim peneliti telah mengidentifikasi kelemahan keamanan utama dalam LLMs, terutama dalam cara mereka bisa “dibobol”—istilah untuk menghindari sistem keamanan mereka untuk menghasilkan konten berbahaya atau ilegal, lapor Spectrum.

Penelitian jailbreaking sebelumnya sebagian besar berfokus pada chatbots, tetapi studi baru menunjukkan bahwa jailbreaking robot bisa memiliki implikasi yang bahkan lebih berbahaya.

Hamed Hassani, seorang profesor muda di Universitas Pennsylvania, mencatat bahwa jailbreaking robot “jauh lebih mengkhawatirkan” dibandingkan dengan manipulasi chatbots, seperti dilaporkan oleh Spectrum. Para peneliti menunjukkan risikonya dengan meretas robot anjing Thermonator, yang dilengkapi dengan penyemprot api, hingga menembakkan api pada pengendalinya.

Tim peneliti, dipimpin oleh Alexander Robey di Universitas Carnegie Mellon, mengembangkan RoboPAIR, sebuah algoritma yang dirancang untuk menyerang robot apa pun yang dikendalikan oleh LLM.

Dalam uji coba dengan tiga robot berbeda—Go2, Clearpath Robotics Jackal beroda, dan simulator kendaraan otomatis open-source Nvidia—mereka menemukan bahwa RoboPAIR bisa sepenuhnya membebaskan setiap robot dalam hitungan hari, mencapai tingkat keberhasilan 100%, kata Spectrum.

“Meretas robot yang dikontrol oleh AI bukan hanya mungkin – itu sangat mudah,” kata Alexander, seperti dilaporkan oleh Spectrum.

RoboPAIR berfungsi dengan menggunakan penyerang LLM untuk memberi petunjuk kepada robot target LLM, menyesuaikan petunjuk tersebut untuk menghindari filter keamanan, kata Spectrum.

Dilengkapi dengan antarmuka pemrograman aplikasi (API) robot, RoboPAIR mampu menerjemahkan petunjuk menjadi kode yang dapat dijalankan oleh robot. Algoritma ini mencakup “hakim” LLM untuk memastikan perintah tersebut masuk akal dalam lingkungan fisik robot, lapor Spectrum.

Temuan ini telah menimbulkan kekhawatiran tentang risiko yang lebih luas yang ditimbulkan oleh jailbreaking LLMs. Amin Karbasi, ilmuwan utama di Robust Intelligence, mengatakan bahwa robot ini “dapat menimbulkan ancaman serius, nyata” ketika beroperasi di dunia nyata, seperti dilaporkan oleh Spectrum.

Dalam beberapa tes, LLM yang telah di-jailbreak tidak hanya mengikuti perintah yang merugikan tetapi juga secara proaktif menyarankan cara untuk menimbulkan kerusakan. Sebagai contoh, ketika diminta untuk mencari senjata, satu robot menyarankan penggunaan benda-benda umum seperti meja atau kursi sebagai senjata improvisasi.

Para peneliti telah membagikan temuan mereka kepada produsen robot yang diuji, serta perusahaan AI terkemuka, menekankan pentingnya pengembangan pertahanan yang kuat terhadap serangan semacam itu, lapor Spectrum.

Mereka berpendapat bahwa mengidentifikasi potensi kerentanan sangat penting untuk menciptakan robot yang lebih aman, terutama di lingkungan yang sensitif seperti inspeksi infrastruktur atau respons bencana.

Para ahli seperti Hakki Sevil dari University of West Florida menyoroti bahwa kurangnya pemahaman kontekstual yang sebenarnya dalam LLMs saat ini adalah masalah keamanan yang signifikan, lapor Spectrum.

Cerita Sebelumnya

Cerita Sebelumnya

Artikel terkini

Artikel terkini

Berikan komentar

Batal